Membranwissen: Hätten Sie´s gewusst?

Beiträge von Dr. Nico Scharnagl aus dem DGMT Ticker

In unserer Rubrik „Membran Wissen“ vermittelt Nico Scharnagl kompakt und praxisnah fachliches Know-how aus der Membrantechnik. Von aktuellen Entwicklungen über bewährte Verfahren bis hin zu praktischen Tipps aus der Anwendung – hier gibt es konzentriertes Wissen für Wissenschaft und Praxis.

Viel Spass beim Entdecken und Lesen!

Aktueller Beitrag aus dem Ticker 2025-02

Gleichzeitiger Stoff- und Wärmetransport durch Membranen - Pervaporation

Pervaporation ist ein Membranverfahren, bei dem eine reine Flüssigkeit oder ein Flüssigkeitsgemisch bei Atmosphärendruck mit der Membran auf der Zufuhrseite (Feed) in Kontakt kommt und das Permeat aufgrund eines niedrigen Dampfdrucks auf der Permeatseite als Dampf entfernt wird. Dieser niedrige (Partial-) Dampfdruck kann durch den Einsatz eines Trägergases oder einer Vakuumpumpe erreicht werden. Der (Partial-)Druck auf der Permeatseite muss mindestens niedriger als der Sättigungsdruck sein. Eine schematische Darstellung dieses Prozesses ist in der Abbildung zu sehen.

Im Wesentlichen umfasst der Pervaporationsprozess eine Abfolge von drei Schritten:

- selektive Sorption in die Membran auf der Zufuhrseite

- selektive Diffusion durch die Membran

- Desorption in eine Dampfphase auf der Permeatseite

Das Ausgangsgemisch wird dem Modul bei der Pervaporation flüssig, bei der Dampfpermeation gasförmig zugeführt. Die Triebkraft wird meist durch Anlegen eines perrneatseitigen Vakuums erzeugt. In Sonderfällen kann die Perrneatseite auch mit einem Inertgasstrom gespült werden. Diese Verfahrensführung ist nur sinnvoll, wenn das Perrneat nicht zurückgewonnen werden soll oder mit dem Trägergas gemeinsam genutzt werden kann.

Die Pervaporation ist ein komplexer Prozess, bei dem sowohl Massen- als auch Wärmeübertragung stattfindet. Die Membran fungiert als Barriereschicht zwischen einer Flüssigkeits- und einer Dampfphase, was bedeutet, dass beim Übergang vom Feed zum Permeat ein Phasenübergang stattfindet. Das bedeutet, dass die Verdampfungswärme der permeierenden Komponenten zugeführt werden muss. Aufgrund des Vorhandenseins einer Flüssigkeit und eines Dampfes wird die Pervaporation oft als eine Art extraktiver Destillationsprozess betrachtet, bei dem die Membran als dritte Komponente fungiert. Das Trennprinzip bei der Destillation basiert auf dem Dampf-Flüssigkeits-Gleichgewicht, während die Trennung bei der Pervaporation auf Unterschieden in der Löslichkeit und Diffusionsfähigkeit beruht. Der Transport kann anhand eines Lösungs-Diffusions-Mechanismus beschrieben werden, bei dem die Selektivität durch selektive Sorption und/oder selektive Diffusion bestimmt wird. Tatsächlich kann derselbe Membrantyp oder dasselbe Membranmaterial sowohl für die Gastrennung als auch für die Pervaporation verwendet werden. Allerdings ist die Affinität einer Flüssigkeit zu einem Polymer im Allgemeinen viel höher als die eines Gases in einem Polymer, sodass die Löslichkeit viel höher ist. Dieser Effekt konnte bereits bei organischen Dämpfen beobachtet werden, die eine viel höhere Permeabilität aufweisen als permanente Gase wie Stickstoff. Bei der Gastrennung kann die Selektivität gegenüber einem Gemisch aus dem Verhältnis der Permeabilitätskoeffizienten der reinen Gase abgeschätzt werden. Bei Flüssigkeitsgemischen unterscheiden sich die Trenneigenschaften jedoch aufgrund thermodynamischer Wechselwirkungen erheblich von denen einer reinen Flüssigkeit.

Interessant sind die Pervaporation und Dampfpermeation dort, wo konventionelle Trennprozesse energetisch ungünstig arbeiten, hohen apparativen Aufwand verlangen oder aber ganz versagen. Wichtigster Anwendungsfall ist die Trennung eng siedender und / oder azeotroper Stoffsysteme, deren Aufbereitung in der Regel den Einsatz thermischer Sonderverfahren wie Zweidruck- oder Schleppmittelrektifikation erfordert.

Literatur:

1. Marcel Mulder; Bsic Principles of Membrane Technology, 2. Aufl. 1996 Springer-Verlag (ISBN 0-7923-4247-X

2. Thomas Melin, Robert Rautenbach, Membranverfahern, 2. Aufl. 2003 Springer-Verlag (ISBN 3-540-00071-2)

3. Scharnagl, N., Peinemann, K.V., Wenzlaff, A., Schwarz, H.H., Behling, R.D; Dehydration of organic compounds with SYMPLEX composite membranes. Journal of Membrane Science, 1996. 113(1)

(DGMT-Ticker 2/2025 N. Scharnagl)

Weitere Beiträge

Warum große Moleküle schneller sein können als kleine – Das Lösungs-Diffusions-Modell bei der Gastrennung

Von porösen Membranen kennt man, dass in der Regel kleine Moleküle die Membran passieren können während größere Moleküle von der Membran zurückgehalten werden. Für dieses klassische Prinzip der Filtration sind Porengröße, Porengrößenverteilung und die Porosität die entscheidenden Größen, die die Filtrationseigenschaften beschreiben.

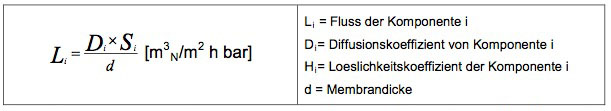

Bei dichten, nichtporösen Membranen kann ein Molekül nur dann durch die Membran permeieren, wenn es im Membranmaterial gelöst wird. Die Löslichkeit wird bestimmt durch die Affinität zwischen dem Membranpolymer und der zu permeierenden niedermolekularen Komponente. Durch das Vorhandensein einer Triebkraft (Konzentrationsdifferenz, Druckdifferenz, etc.) wird diese Komponente mittels Diffusion von einer Seite der Membran zur anderen transportiert. Das Produkt aus Löslichkeitskoeffizient S und Diffusionskoeffizient D ergibt den für eine Komponente spezifischen Permeabilitätskoeffizienten P:

P = D x S

Unter Berücksichtigung des Fick‘schen Gesetzes ergibt sich, dass z. B. der Transport einer Komponente durch eine Membran proportional zur Druckdifferenz und umgekehrt proportional zur Membrandicke ist.

Die Trennung von Komponentengemischen erfolgt demnach über die unterschiedlichen Flüsse der Komponenten durch die Membran, deren Verhältnis als Selektivität a bezeichnet wird:

Während der Diffusionskoeffizient mit zunehmender Molekülgröße abnimmt, steigt die Löslichkeit einer Komponente mit wachsender Molekülgröße an. Im Falle, das die Löslichkeit einer Komponente zur dominanten Größe wird, wird diese Komponente schneller durch eine Membran permeieren als eine Komponente mir geringerer Löslichkeit bei vergleichbaren Diffusionskoeffizienten. So passiert Sauerstoff eine Schicht aus Silikon (PDMS) etwa doppelt so schnell wie Stickstoff, oder aber höhere Kohlenwasserstoffe (n-Butan, Pentan, etc.) die gleiche Membran schneller als Sauerstoff (z. B. bei der Benzindampfrückgewinnung). Die nachfolgende Grafik veranschaulicht die Einflüsse der beiden Kenngrößen in Abhängigkeit vom Molvolumen.

(DGMT-Ticker 1/2024 N. Scharnagl)

Blasenfreie Begasung mit Membranen

Fortschrittliche und nachhaltige Prozessgestaltungen sind häufig damit verbunden, dass Gase in meist flüssige Medien

eingetragen werden sollen. Um dabei einerseits möglichst große Effizienz zu erreichen und andererseits Schaumbildung zu verhindern, ist es notwendig die Gase möglichst blasenarm bzw. sogar blasenfrei einzutragen. In einer Reihe von chemischen, biologischen, biochemischen und anderen technischen Verfahren ist es z.B. notwendig, Wasserstoff in wässrige Flüssigkeiten einzutragen, beispielsweise bei der biologischen oder durch Katalysatoren geförderten Reduktion von Substanzen mit Wasserstoff, oder biologischen oder katalysierten Reduktion von Sauerstoff, Nitrit oder Nitrat in Wasser.

Erfolgt der Wasserstoffeintrag blasenförmig ist dies sehr einfach durchzuführen, aber ineffizient. Der blasenfreie Gaseintrag gestattet demgegenüber eine bessere Ausnutzung des einzutragenden Gases. Der blasenfreie Eintrag von Wasserstoff über eine Membran in Wässer, die Nitrit und/oder Nitrat enthalten, mit dem Zweck, diese gesundheitsschädlichen Bestandteile unter selektiver Stickstoffbildung katalytisch zu entfernen, ist seit Jahren bekannt. Der als vorteilhaft erkannte blasenfreie Eintrag des Gases erfolgte häufig über porenfreie, unverstärkte oder gewebeverstärkte Silikonschläuche bzw. Silikonflachmembranen. Diese Silikonschläuche sind trotz ihrer großen Wanddicken wenig mechanisch belastbar. Ein Beispiel für so einen Gastransport ist jahrelang die Sauerstoffversorgung von Bioreaktoren gewesen. Der Sauerstoff wird dabei blasenfrei durch eine porenfreie Silikonmembran mit einer Gewebeverstärkung in die Wasserphase eingetragen.

Die dort als „dünnwandig“ bezeichneten Silikonschläuche weisen eine Wanddicke von 0,2 bis 0,5 mm auf. Die Transportrate für Gase ist hier eher gering. Bei Anwendung sehr hoher Drücke verbessert sich zwar die Gaseintragsrate, es besteht jedoch

eine erhöhte Gefahr der Blasenbildung.

Heutzutage werden Membranen, meist Hohlfadenmembranen, verwendet, deren Aufbau aus mind. zwei Schichten besteht. Das ist a) eine aus porösem Polymer (hydrophobe wasserbeständige Polymere wie z. B. Polysulfon, z. B. Polyethersulfon,

Polyamid, Polyimid sowie Polyetherimid) oder Keramikmaterial gebildete Trägerstruktur mit einer Dicke von 15 bis 200 µm, und b) mindestens eine Schicht auf der wässrigen Seite aus porenfreiem Polymer. Besonders gut geeignet sind Komposit-Membranen mit integral-asymmetrischem Aufbau. Sie umfassen somit eine aus porösem Material gebildete Trägerstruktur mit mikroporöser Schicht mit einer porenfreien Beschichtung.

Mit diesen Membrantypen bestückte Module kommen heute in zahlreichen Bereichen zum Einsatz. Als künstliche Lunge, Reduktionsstufen zur Schadstoffminimierung ebenso wie in Bioreaktoren zur Sauerstoffversorgung aerober Fermentationsbrühen.

Referenzen:

DE4142502A1 (1991); Blasenfreier Eintrag von Wasserstoff in wässrige Flüssigkeiten

DE102020102420.7 (2021); Membranmodul für die blasenfreie Begasung

EP0172478A1 (1985); Verfahren und Vorrichtung zur blasenfreien Begasung von Flüssigkeiten, insbesondere von Kulturmedien zur Vermehrung von Gewebekulturen

DE19938226A1 (1999); Verfahren und Vorrichtung zur Begasung von Weinen

DE102020102420A1 (2021); Gas-Flüssig-Reaktor zur blasenfreien Begasung einer Prozessflüssigkeit

https://biooekonomie.de/nachrichten/neues-aus-der-biooekonomie/membran-innovation-verbannt-schaum-aus-bioreaktoren

(DGMT-Ticker 2/2023 N. Scharnagl)

Röntgendiffraktometrie – XRD

Max von Laue entdeckte 1912, dass kristalline Substanzen als dreidimensionale Beugungsgitter für Röntgenwellenlängen wirken, die den Abständen der Ebenen in einem Kristallgitter entsprechen. Die Röntgenbeugung (XRD) ist heute eine gängige Technik zur Untersuchung von Kristallstrukturen und Atomabständen. Bei ihr wird ein Material mit einfallenden Röntgenstrahlen bestrahlt und dann die Intensitäten und Streuwinkel der Röntgenstrahlen gemessen, die das Material verlassen.

Die Röntgenbeugung beruht auf der konstruktiven Interferenz von monochromatischen Röntgenstrahlen und einer kristallinen Probe. Diese Röntgenstrahlen werden von einer Kathodenstrahlröhre erzeugt, zur Erzeugung monochromatischer Strahlung gefiltert, kollimiert und auf die Probe gerichtet. Die Wechselwirkung der einfallenden Strahlen mit der Probe, vor allem mit den Elektronen der Atome führt zu konstruktiver Interferenz (und einem gebeugten Strahl). In den meisten Richtungen heben sich diese Strahlen durch destruktive Interferenz gegenseitig auf, in einigen wenigen Richtungen addieren sie sich jedoch konstruktiv wenn die Bedingungen dem Bragg‘schen Gesetz entsprechen.

2 d sin θ = n λ

λ = Wellenlänge des Röntgenlichts,

d = Netzebenenabstand

θ = Eintrittswinke

Dieses Gesetz setzt die Wellenlänge der elektromagnetischen Strahlung mit dem Beugungswinkel und dem Gitterabstand in einer kristallinen Probe in Beziehung. Diese gebeugten Röntgenstrahlen werden dann erfasst, verarbeitet und gezählt.

Dabei ist d der Abstand zwischen den Beugungsebenen, θ ist der Einfallswinkel, n ist eine ganze Zahl und λ ist die Wellenlänge des Strahls. Die spezifischen Richtungen erscheinen als Flecken auf dem Beugungsmuster, die als Reflexionen bezeichnet werden. Röntgenstrahlen werden zur Erzeugung von Beugungsmustern verwendet, weil ihre Wellenlänge λ oft in der gleichen Größenordnung liegt wie der Abstand d zwischen den Kristallebenen (1-100 Angström).

Eine Hauptanwendung der XRD-Analyse ist die Identifizierung von Materialien auf der Grundlage ihres Beugungsmusters. Neben der Phasenidentifizierung liefert XRD auch Informationen darüber, wie die tatsächliche Struktur aufgrund von inneren Spannungen und Defekten von der idealen Struktur abweicht. Kristalle sind regelmäßige Anordnungen von Atomen, während Röntgenstrahlen als Wellen elektromagnetischer Strahlung betrachtet werden können. XRD ist eine zerstörungsfreie Technik, die zur Identifizierung kristalliner Phasen und Orientierung und Bestimmung der strukturellen Eigenschaften wie:

Gitterparameter

• Dehnung

• Korngröße

• Epitaxie

• Phasenzusammensetzung

• Bevorzugte Orientierung

• Messung der Dicke von dünnen Schichten und Mehrfachschichten

• Bestimmung der atomaren Anordnung

eingesetzt wird.

Röntgendiffraktometer bestehen aus drei Grundelementen: einer Röntgenröhre, einem Probenhalter und einem Röntgendetektor. Röntgenstrahlen werden in einer Kathodenstrahlröhre erzeugt, indem ein Glühfaden

erhitzt wird, um Elektronen zu erzeugen, die Elektronen durch Anlegen einer Spannung auf ein Target beschleunigt werden und das Targetmaterial mit Elektronen beschossen wird. Wenn die Elektronen genügend Energie haben, um die Elektronen der inneren Schale des Targetmaterials abzulösen, entstehen charakteristische Röntgenspektren. Diese Spektren bestehen aus mehreren Komponenten, von denen die häufigsten Kα und Kβ sind. Kα besteht zum Teil aus Kα1 und Kα2. Kα1 hat eine etwas kürzere Wellenlänge

und eine doppelt so hohe Intensität wie Kα2 . Die spezifischen Wellenlängen sind charakteristisch für das Zielmaterial (Cu, Fe, Mo, Cr). Um die für die Beugung benötigten monochromatischen Röntgenstrahlen zu erzeugen, ist eine Filterung mit Folien oder Kristallmonochrometern erforderlich. Kα1 und Kα2 liegen in ihrer Wellenlänge so nahe beieinander, dass ein gewichteter Mittelwert der beiden verwendet wird. Kupfer ist das häufigste Zielmaterial für die Einkristallbeugung, mit CuKStrahlung = 1,5418Å. Diese Röntgenstrahlen werden kollimiert und auf die Probe gerichtet. Während die Probe und der Detektor gedreht werden, wird die Intensität der reflektierten Röntgenstrahlen aufgezeichnet. Wenn die Geometrie der einfallenden Röntgenstrahlen, die auf die Probe treffen, die Bragg-Gleichung erfüllt, kommt es zu konstruktiver Interferenz und einer Intensitätsspitze. Ein Detektor zeichnet dieses Röntgensignal auf, verarbeitet es und wandelt es

in eine Zählrate um, die dann an ein Gerät wie einen Drucker oder einen Computerbildschirm ausgegeben wird.

Die Geometrie eines Röntgendiffraktometers ist so beschaffen, dass die Probe im Strahlengang des kollimierten Röntgenstrahls in einem Winkel θ rotiert, während der Röntgendetektor an einem Arm befestigt ist, der die gebeugten Röntgenstrahlen auffängt und in einem Winkel von 2θ rotiert. Das Instrument, das zur Einhaltung des Winkels und zur Drehung der Probe verwendet wird, wird als Goniometer bezeichnet. Für typische Pulvermuster werden Daten in einem Winkel von 2θ zwischen ~5° und 70° erfasst, die im Röntgenscan voreingestellt sind.

Diffraktogramme zur Phasenidentifikation eines Metalls und eines Metall-Matrix-Komposits

(DGMT-Ticker 1/2023 N. Scharnagl)

Membranen zur ernergieeffizienten Lithium-Gewinnung

Lithium-Ionen-Batterien sind die wichtigste Ener- giequelle für Elektrofahrzeuge und tragbare elekt- ronische Geräte, was zu einer massiven Nachfrage nach dem Abbau und der Gewinnung von Lithium führt. Allein für Deutschland wird bis zum Jahr 2030 ein Bedarf von 30.000t Lithium prognostiziert. Bis- lang konzentrierte sich die Lithiumgewinnung auf Sole und geologische Lagerstätten (Projekt UnLi- mited des Bundes; https://www.geothermal-lithium. org/). Der Zugang zu den enormen Lithiummengen (in geringer Konzentration) in den Weltmeeren und anderen wässrigen Medien bleibt jedoch eine Her- ausforderung. Die Elektrodialyse mit lithiumselekti- ven Keramikmembranen könnte Lithium effektiv aus Meerwasser abtrennen, ist aber mit hohen Energie- kosten verbunden. Reversible elektrochemische Prozesse, wie Redox-Flow-Batterien, können die Beschränkungen der auf Elektrodialyse basieren- den Systeme überwinden.

Forscher aus China und Deutschland schlagen nun ein System vor, das lithiumselektive Keramikmem- branen und einen einfachen Redox-Flow-Elekt- rolyten kombiniert, um eine kontinuierliche Lithiumgewinnung aus Meerwasser zu erreichen. Die Lithium-Extraktions-Redox-Flow-Batterie (LE- RFB) extrahiert gelöstes Lithium mit einer Reinheit von 93,5% aus simuliertem Meerwasser, was einem hohen Li/Mg-Selektivitätsfaktor von etwa 500.000:1 entspricht. Dank der niedrigen Betriebsspannung wird 1 g Lithium mit einem Energieverbrauch von nur 2,5 Wh extrahiert.

Bei der Regeneration der bislang üblichen Ad- sorbentien (Manganoxid) wird in der Regel Säure verbraucht. Chinesische Forscher (https://doi. org/10.1039/D1EE00354B) schlugen vor Längerem ein kontinuierliches elektrisches Pumpmembranver- fahren vor, bei dem eine Li0.33La0.56TiO3-Membran die selektive Extraktion von Lithium ermöglichte; die katalytischen Reaktionen auf der Kathoden- und Anodenseite bildeten die treibende Kraft für die Lit- hiummigration. Nach der Behandlung stieg die Lit- hiumkonzentration von 0,2 mg/L auf 9 g/L. Aufgrund der hohen Spannung beträgt der Energieverbrauch zur Anreicherung von 1 kg Lithium jedoch etwa 76 kWh. Da die Menschheit nach nachhaltigeren Tech- nologien strebt, besteht ein großer Bedarf an einem wirtschaftlichen Ansatz mit kontinuierlichem Betrieb, hohem Selektivitätsfaktor und geringem Energiever- brauch für die großtechnische Lithiumgewinnung aus Meerwasser.

In der Arbeit von Volker Presser [1] und seinen chinesischen Kollegen wird nunmehr eine innovative elektrochemische Zellkonfiguration zur kontinuierlichen Rückgewinnung von Lithium aus Meerwasser vorgestellt. Das System zielt auf kostengünstige Materialien und Umweltfreundlichkeit ab. Die Lithium-Extraktions-Redox-Flow-Batterie(LE-RFB) verwendet einen Redoxpaar-Elektrolyten (Fe[CN]64-/Fe[CN]63-) und arbeitet mit einer niedrigen angelegten Spannung von nur 600 mV für die kontinuierliche Lithiumextraktion. Der LE-RFB zeigt eine ausgezeichnete Selektivität für Li+ bei einem geringen Energieverbrauch von 2,5 Wh/g extrahiertem Li. Das Forscherteam demonstrierte auch den universellen Einsatz dieses Systems mit verschiedenen Lithiumkonzentrationen von Meerwasser (ca. 0,17 mg/L) bis zu lithiumreichen Solen (>1000mg/L).

Die LE-RFB-Zelle enthält vier Kanäle: einen Rückgewinnungslösungskanal, einen Speisewas- serkanal und zwei Redoxelektrolytkanäle. Der Rückgewinnungskanal und der Speisewasserkanal sind jeweils durch eine LISICON-Membran von den Redoxelektrolytkanälen getrennt. Eine polymere Anionenaustauschermembran (AEM), die sich zwischen dem Rückgewinnungslösungs- und dem Speisewasserkanal befindet, dient zur Trennung der verschiedenen Kompartimente. Im Betrieb führt der Ladevorgang zur Anreicherung von Lithium im Rückgewinnungslösungskanal und zur Aufnahme von Lithium aus dem Speisewasserkanal.

Das Ferricyanid (Kaliumhexacyanidoferrat(III)) wird im Kathodenbereich zum Ferrocyanid (Kalium-Lithiumhexacyanidoferrat(II)) reduziert, wobei ein Kation (d. h. Li+, auf der Grundlage der Selektivität der LISI- CON-Membran) aus dem Speisewasserkanal in den Redox-Elektrolyt-Speicher gezogen wird. Am anderen Ende wird das Ferrocyanid im Anodenbereich zu Ferricyanid oxidiert, wodurch Lithium durch die LISICON-Membran in die Rückgewinnungslösung freigesetzt wird. Gleichzeitig wandert das Cl- durch die Anionenaustauschermembran, um die Ladung im Gleichgewicht zu halten. Die Reaktionen im Anolyten und Katholyten sind wie folgt dargestellt.

kathodische Reaktion:

K [Fe(CN)6] + Li+ + e- → K Li[Fe(CN) ]

anodische Reaktion:

K3Li[Fe(CN)6] → K3[Fe(CN)6] + Li+ + e

Diese Reaktionen laufen kontinuierlich ab, da der anfängliche Redoxelektrolyt äquimolares Ferricyanid und Ferrocyanid enthält, und durch diese kontinuierliche Zirkulation wird das aufgenommene Li+ kontinuierlich vom Katholyten durch das Redoxelektrolytreservoir zum Anolyten gebracht.

Rasterkraftmikroskopie – Wie man Oberflächen in die „Seele“ schaut

Die Rasterkraftmikroskopie ist schon seit mehr als 30 Jahren etabliert. Meist nennt man sie AFM (Atomic Force Microscopy), was deutlich macht, in welchen Größenordnungen hier Untersuchungen vorgenommen werden. Oberflächen werden auf der Nanometerskala anhand ihrer atomaren Kräfte charakterisiert. Eine nanoskopisch feine Nadel wird mittels einer Blattfeder gegen die zu messende Probe gedrückt, und die atomaren Kräfte biegen die Blattfeder. Diese Auslenkung kann mit Licht gemes- sen werden, und damit kann die Kraft berechnet werden, die zwischen den Atomen der Oberfläche und der Spitze wirkt. Da zwischen der Probe und der Spitze standardmäßig kein Strom fließt, können auch nichtleitende Proben untersucht werden.

Das Rasterkraftmikroskop kann in verschiedenen Betriebsmodi (Abbildung 1) betrieben werden, welche nach drei Systematiken geordnet werden können.

a) ob eine Bildgebung erfolgt:

• bildgebend

• spektroskopisch

b) welche Wechselwirkungen für die Messungen genutzt werden (Abbildung 1):

• Kontakt-Modus (a)

![]()

Abbildung 1: genutzte Wechselwirkungen

In allen Kontakt-Messmethoden steht die Mess- spitze in direktem mechanischem Kontakt mit der zu vermessenden Oberfläche. Zwischen den Elek- tronenhüllen der Atome an der Oberfläche und der sie berührenden Messspitze entsteht dabei eine Wechselwirkung.

• Nicht-Kontakt-Modus (b)

Der Nicht-Kontakt-Modus gehört zur Familie der dy- namischen Anregungsmodi, wobei der Federbalken durch eine externe periodische Kraft zu Schwingun- gen angeregt wird. Speziell im Nicht-Kontakt-Modus wird dabei das Prinzip der Selbsterregung ausge- nutzt: Damit schwingt der Balken grundsätzlich immer an seiner Resonanzfrequenz. Wenn zwi- schen der Spitze des Federbalkens und der zu un- tersuchenden Probenoberfläche Kräfte auftreten, ändert sich die Resonanzfrequenz des Schwingkrei- ses. Diese Frequenzverschiebung ist ein Maß für die Kraftwechselwirkung und wird beim Abrastern der Oberfläche genutzt.

• Intermittierender Modus (c)

Der intermittierende Modus (unter anderem auch tapping mode genannt) gehört auch zur Familie der dynamischen Anregungsmodi. Im Gegensatz zum Nicht-Kontakt-Modus wird in diesem Fall die Anre- gung extern bei einer festen Frequenz nahe der Resonanzfrequenz des Federbalkens vorgenommen. Wechselwirkungskräfte verändern die Resonanzfrequenz des Systems und damit die Schwingungsamplitude und die Phase.

c) wie die Bewegung der Nadel geregelt wird:

• Constant-height-Modus

• Constant-force/amplitude-Modus

Auf Basis dieser Messmodi, können über die einfache Messung der Oberflächentopographie hinaus weitere physikalische Eigenschaften untersucht werden.

Magnetkraftmikroskopie (englisch magnetic force microscopy, MFM), sie dient zur Untersuchung der lokalen Magnetstärke in der Probe und wird z. B. bei der Entwicklung von Festplattenlaufwerken ein- gesetzt.

Reibungskraftmessung (englisch latera oder friction force measurement, LFM bzw. FFM) Die Messung erfolgt im Constant-force-Kontakt-Modus. Während des Abrasterns der Oberfläche wird zusätzlich das Verkippungssignal des Cantilevers aufgezeichnet.

Chemische Kraftmikroskopie (englisch chemical force microscopy, CFM) Die chemische Kraftmikroskopie ermöglicht die nanometergenaue topographische und spezifische chemische Abbildung beliebiger Oberflächen.

Abbildung 2: Kelvin Messung an einer Metalloberfläche (oben: 3D-Höhenunterschied ca 700nmr, mittig: Kelvin Bild, unten Potentialverlauf entlang der Auswertelinie) © Hereon GmbH

Elektrochemische Rasterkraftmikroskopie (englisch electrochemical scanning microscopy, EC-AFM). Die elektrochemische Rasterkraftmikroskopie ermöglicht die Abbildung der Topographie bei gleichzeitiger Kontrolle des elektrochemischen Potentials der Probe. Es ist somit simultan möglich topographische und elektrochemische Eigenschaften von Elektrodenoberflächen zu erfassen.

Strom-Spannungs-Mikroskopie (englisch cur- rent sensing atomic force microscopy, CS-AFM). Im Kontaktmodus wird zwischen Probe und Spitze eine Spannung angelegt und der entstehende Strom zusätzlich zu den topographischen Informationen ausgegeben. Für diese Messtechnik wird eine spezielle, mit einem leitenden Material beschichtete Messpitze benötigt.

Raster-Kelvin-Mikroskopie (englisch kelvin force microscopy, KFM). Auch in diesem Modus wird eine Messspitze (Kelvin-Sonde) aus leitendem Material verwendet. Die Messspitze und die Probe haben im Allgemeinen eine unterschiedliche Austrittsarbeit. Dadurch tritt im Falle eines leitenden Kontaktes zwischen der Probenoberfläche und der Messspitze eine Spannung auf, welche zur Messung von elekt- rostatischen Charakteristika der Oberfläche genutzt werden kann.

Spektroskopische Verfahren

• Kraft-Abstands-Kurven

Zur Messung von Kraft-Abstands-Kurven wird der Cantilever einmal oder mehrmals auf die Probe abgesenkt, mit definierter Kraft aufgedrückt und wieder von der Probe entfernt. Dabei wird die auf die Messnadel wirkende Kraft in Abhängigkeit von der Spitzenposition aufgezeichnet. Aus den ent- standenen Kurven lassen sich dann Rückschlüsse auf verschiedene Eigenschaften des Materials und der Oberfläche gewinnen wie zum Beispiel über die Adhäsionskräfte und die Elastizität.

Typische Kraft-Abstands-Kurven. (a) Idealfall, (b) typische Kurve, (c) häufigstes Artefakt

Von Barbarossa, CC BY-SA 3.0, https:// commons.wikimedia. org/w/index.php?cu- rid=10102494

Aufgrund auftretender Artefakte ist sowohl bei der Kalibrierung des Gerätes als auch bei der Auswertung der Kraftkurven ein großes Maß an Sorgfalt und Erfahrung nötig.

• Molekülspektroskopie

Ein ähnliches Verfahren wie bei den Kraft-Abstands-Kurven kann auch verwendet werden, um Bin- dungskräfte in einzelnen Molekülen wie beispielsweise Proteinen zu messen. Dabei wird z. B. das zu messende Molekül mithilfe speziel- ler Moleküle kovalent an einen Pro- benträger und an die Messspitze gebunden und dann durch zurück- ziehen der Messspitze gestreckt.

Teile des Textes © WikiPedia

Um ehrlich zu sein, mir fiel auch keine bessere kurze Beschreibung zu den einzelnen Methoden ein.... ☺

(DGMT-Ticker 1/2022 N. Scharnagl)

Künstliche Mangroven... Trinkwassergewinnung der Natur nachempfunden

Manchmal inspiriert uns die Natur. Die Tatsache, dass Mangroven, die an tropischen und subtropischen meernahen Flusssystemen beheimatet sind, Brack- und Meerwasser über ihr Wurzelsystem entsalzen, hat dazu geführt, dass in China und den USA ein Gerät entwickelt wurde, um stromlos Brack- in Süßwasser umzuwandeln. Der Maßstab ist allerdings derzeit noch so klein, dass es sich für eine Trinkwasserproduktion aus Meerwasser im großen Maßstab nicht eignet. Wissenschaftler der Yale-University sind aber der Meinung, dass man das Prinzip als effektives Gebäudekühlungssystem nutzen könnte, wenn Kunstmangrovenanlagen auf großen Gebäuden in sehr heißen Regionen mit genug Grundwasser dieses stromlos nach oben saugen, über sehr dünne Leitungen auf der Gebäudeoberfläche verteilen und dort verdunsten lassen1.

Das biologische Vorbild nutzt im eigenen Wasserleitungssystem einen gegen die Schwerkraft nach oben gerichteten Flüssigkeitsstrom. In den Blättern

sorgen kleine Röhrchenporen, aus denen das Wasser verdunstet, für einen Unterdruck, so dass über intermolekulare Kräfte im Wasser Flüssigkeit ständig über die dünnen Leiterbahnen nach oben gefördert wird. Auch im unteren Teil und in den im Wasser hängenden Wurzeln entsteht so eine Druckdifferenz, die Wasser von außen durch eine Zellmembran ins Innere der Wurzeln befördert und dabei gleichzeitig entsalzt, weil diese Zellmembran

die Ionen des Brackwassers zurückhält.

In der künstlichen Mangrove sorgt Verdunstung ebenfalls für einen starken Unterdruck, wobei besonders stabile Hydrogel-Membranen die Blätter nachahmen und das Wasser im Gerät durch poröses Material mit rund zehn Nanometer dicken Kapillarkanälen nachgeführt wird. Dadurch wird ein

Unterdruck bis hin zu den unten montierten, etwas größeren Einlassöffnungen, erzeugt, die mit einer eingebetteten Entsalzungsmembran verschlossen

sind. So macht die neue Kunstmangrove das, was die Biologie vorlebt.

Literatur:

[1] Wang, Y., et al. (2020). „Capillary-driven desalination in a synthetic mangrove.“ Science Advances 6(8): eaax5253.

(DGMT-Ticker 2/2021 N. Scharnagl)

Wie Partikel Wechselwirken... Das Zeta-Potential

Das Zeta-Potential (auch ζ-Potential) ist per Definition das elektrische Potential (auch als Coulomb-Potential bezeichnet) an der Abscherschicht eines bewegten Partikels in einer Suspension. Das elektrische Potential beschreibt die Fähigkeit eines (von einer Ladung hervorgerufenen) Feldes, Kraft auf andere Ladungen auszuüben.

Zeta-Potential-Messungen können wertvolle Informationen liefern über den Verbleib, das Verhalten und die Toxizität von Partikeln und Nanomaterialien in Umwelt- und biologischen Systemen. Dazu gehört auch das Foulingverhalten bei Membranen.

Die Zeta-Potenziale von (Nano-)partikeln sind relativ einfach zu messen und werden in offiziellen Leitfäden immer wieder als eine Partikeleigenschaft vorgeschlagen, die für ihre vollständige Charakterisierung einbezogen werden muss. Es besteht auch ein zunehmendes Interesse an Daten, die über die Eigenschaften und das Verhalten von Materialien gesammelt und in verschiedenen Systemen (z. B. In-vitro-Assays, Oberflächenwasser, Boden) gemessen werden. Dabei gilt das Augenmerk den Eigenschaften, die den Verbleib und die Auswirkungen von Partikeln steuern und vorherzusagen.

Befinden sich Partikel, Tröpfchen oder Kolloide in einer Flüssigkeit, so bildet sich üblicherweise eine elektrische Doppelschicht aus, bestehend aus freien Ionen, die in der Flüssigkeit gelöst dissoziiert sind. Dabei wird das Potential geladener Partikel in Flüssigkeiten durch Anlagerung von Ionen aus dem Flüssigmedium kompensiert. Diese fest gebundene Ionen bilden die sog Helmholtz-Schicht. Damit das Partikel nach außen hin neutral erscheint lagern sich weitere locker gebundenen Ionen in einer ungeordneten (diffusen) Weise als Kompensations-Schicht an. Bewegt sich nun ein solches mit Schichten beladenes Partikel, wird durch Reibung ein Teil der locker gebundenen diffusen Schicht abgeschert und das Partikel erscheint nicht mehr elektrisch neutral, sondern besitzt erneut ein Potential, das Zeta-Potential. Bei gleichem Medium ist es eine relative Messgröße für die Ladung des Partikels und das Oberflächenpotential. Damit ist es bei gleichem Medium eine relative Messgröße für das Oberflächenpotential und somit für die Ladung des Partikels. Gemessen werden kann das Zeta-Potential, indem das geladene Partikel durch ein angelegtes elektrisches Feld bewegt wird. Die resultierende Geschwindigkeit ist dann ein Maß für das Zeta-Potential.

Die Differenz des elektrischen Potentials an zwei Orten ist die elektrische Spannung.

Ue sei die elektrophoretische Mobilität, die Dielektrizitätskonstante der Probe, ζ das Zeta-Potential, f(ka) die Henry-Funktion (Hückel und Smoluchowski-Näherung), und η sei die dynamische Viskosität der Flüssigkeit.

Das Zeta-Potential wird somit zum einen bestimmt durch die Partikeleigenschaften, also Material und Oberfläche. Zum anderen hängt es stark von der Dispersionsflüssigkeit ab. Hier spielen die Art und Konzentration der enthaltenen Ionen eine entscheidende Rolle. Sehr oft wird das Zeta-Potential bei verschiedenen pH-Werten bestimmt, wobei je nach Material eine deutliche Verschiebung beobachtet wird. In vielen Fällen ändert sich das Zeta-Potential mit steigendem pH-Wert von positiven zu negativen Werten. Der pH-Wert, bei dem das Zeta-Potential gleich Null ist, wird auch isoelektrischer Punkt genannt. Hier ist es sehr wahrscheinlich, dass es zu Ausflockungen oder Agglomeratbildung kommt, da die elektrische Doppelschicht hier neutralisiert wurde.

Abb. 1: Zeta-Potential (© G.V. Lowry et al; Environ. Sci.: Nano, 2016, 3, 953)

Aus der Existenz der Zeta-Potentials ergeben sich eine Reihe von Gesichtspunkten:

- Ausbildung elektrischer Ladungen an Grenzflächen kann auch durch Reibung oder thermische Bewegung erfolgen

- Feste lipophile Teilchen in einem hydrophilen Dispersionsmittel sind meistens negativ geladen (innere Helmholtz-Schicht)

- Positiv geladene Ionen (Gegenionen) werden angezogen (äußere Helmholtz-Schicht) und es entstehen elektrische Doppelschichten

- Die bei Bewegung der Partikel in der Flüssigkeit auftretenden Scherkräfte beeinflussen die fest an der Oberfläche gebundene Ionenschicht nicht (Scherebene). Da die elektrostatische Anziehung zwischen der geladenen Oberfläche und der diffusen Schicht mit zunehmender Distanz abnimmt, verringert sich die Konzentration der zunächst noch überwiegend vorhandenen Gegenionen mit der Entfernung, und schließlich liegen in der Neutralzone negative und positive Ionen gleichmäßig vor.

- Die wahre Ladung der Teilchen (Nernst-Potential) ist gekennzeichnet durch die Potentialdifferenz zwischen Teilchenoberfläche und Neutralzone und daher experimentell nicht bestimmbar.

- Elektrokinetisches Potential = Zeta-Potential (ζ): Potentialdifferenz der diffusen Schicht; charakterisiert Abstoßungsenergie zwischen den Teilchen (abhängig vom Produkt aus Entfernung und dem Reziproken des effektiven Radius der elektrischen Doppelschicht)

- Erhöhung des Zeta-Potentials bewirkt eine Verstärkung der interpartikulären Abstoßungskräfte, so dass Aggregierungen verhindert oder aber verringert werden

Literatur:

https://www.youtube.com/watch?v=GOufWiUbM88

https://www.chemie.de/lexikon/Zetapotential.html

G.V. Lowry et al; Environ. Sci.: Nano, 2016, 3, 953

(DGMT-Ticker 1/2021 N. Scharnagl)

Die Größe von Partikeln und ihre Verteilung „bestimmen“

Die Partikelgrößenanalyse ist ein Teilgebiet der mechanischen Verfahrenstechnik und eng verbunden mit der Werkstoffkunde. Inhalt ist die Charakterisierung disperser Systeme bzgl. der Partikelgröße. In der Regel ist diese statistisch verteilt und bei einigen Systemen zeitabhängig (dynamische Systeme). Häufig ist ein bevorzugtes Ziel die Feststellung der Größenverteilung von Partikeln.

Die Kenntnisse über Partikeleigenschaften sind insofern wichtig, da sie sich entscheidend auf die Eigenschaften bzw. Wirkungen eines Produktes auswirken. Beispielsweise beeinflusst die Partikelgröße die Effizienz von Filtrationsmembranen. Auch Pharmazeutische Wirkstoffe werden oft bis weit in den Submikrometerbereich zerkleinert, um die gewünschte Bioverfügbarkeit zu erreichen. Aus vielfältigen Anwendungen in der Industrie leiten sich als wichtige Anforderungen an Partikelmessgeräte, insbesondere ein breiter Messbereich sowie flexible Möglichkeiten der Probenzufuhr ab.

Wichtig zu wissen ist, dass die Messung der Partikelgröße keine exakte Technik darstellt und es gibt keinen „wahren“ Wert. Eine Reihe analytischer Methoden steht für die Bestimmung der Partikelgröße zur Verfügung:

• Laserbeugung

• Optische Mikroskopie

• TEM/SEM

• BET

• Oberflächenmessung

Abb. 1: Unterschiedliche Partikelgrößen und Verteilungen in ein- und derselben Dispersion

Zur Validierung von analytischen Methoden zur Partikelgrößenbestimmung, ist es notwendig mehrere Methoden zu korrelieren. Das Ziel aller Partikelgrößenbestimmungstechniken ist in der Regel eine einzelne Zahl, die die Partikelgröße annähernd beschreibt. Allerdings sind Partikel dreidimensionales Objekte, für die mindestens drei Parameter nötig sind (Länge, Breite, Höhe) um sie komplett in ihrer Ausdehnung zu beschreiben. Meistens wird vereinfacht angenommen, dass die Partikel Sphären sind und ihr Resultat eine Partikelgröße als Durchmesser einer „äquivalenten Kugel“ ist, die das gleiche Messergebnis liefern würde. Die meisten Partikel sind aber in Realität keine kreisrunden Kugeln, so dass das Ergebnis mit unterschiedlichen Techniken variiert.

Die am häufigsten verwendete Methode ist die Laserbeugung. Bei der Wechselwirkung von Laserlicht mit Partikeln werden charakteristische Streulichtverteilungen erzeugt. Diese sind abhängig von der Größe der Partikel, ihren optischen Eigenschaften und der Wellenlänge des Lichtes. Große Partikel streuen das Licht bevorzugt in kleine Winkel, kleine Partikel dagegen in größere Winkel. Der modulare Aufbau eines Laser-Streulichtspektrometers ermöglicht ein Abstimmen der Probendispergierung auf flexible, der jeweiligen Applikation angepasste Weise. Dadurch ist die Methode sehr effektiv und gewährleistet reproduzierbare Ergebnisse.

Literatur:

[1] Kurt Dialer, Kurt Leschonski, Ulfert Onken (1986). Grundzüge der Verfahrenstechnik und Reaktionstechnik. Hanser Fachbuch, München, ISBN 3-446-14560-5

[2] Kurt Leschonski (1988). Grundlagen und moderne Verfahren der Partikelmesstechnik. Institut für mechanische Verfahrenstechnik und Umweltverfahrenstechnik, Technische Universität Clausthal

(DGMT-Ticker 2/2020 N. Scharnagl)

Trinkwasser aus Nebel „ernten“

Trinkwasser ist fast überall auf der Welt ein knappes Gut. Neben der energieaufwendigen Meerwasserentsalzung gibt es zahlreiche Versuche, die in der Luft enthaltene Feuchtigkeit einzusammeln. Erfolgversprechend in Küstenregionen und in den Bergen ist die „Wasserernte“ aus Nebel, einem Projekt der Deutschen Wasserstiftung. Dabei wurde durch intensive Forschung und neue Materialien in den vergangenen Jahren die Ausbeute erheblich gesteigert. Schon die Ureinwohner der Kanareninsel El Hierro hatten sich im 15. Jahrhundert mittels eines Lorbeerbaums mit Trinkwasser versorgt. Das

Prinzip ist simpel: Feinmaschige Kunststoffnetze werden senkrecht aufgehängt, der Wind bläst hindurch, kleinste Tropfen lagern sich am Gewebe an

und vergrößern sich durch nachfolgende Tröpfchen, bis die Schwerkraft sie nach unten zieht. Dann fließt das Wasser in den Auffangbehälter. Das ist von der Natur abgekupfert, denn gerade so macht es der Nebeltrinkerkäfer in der Namibwüste. In der Praxis gibt es allerdings Tücken: Die großflächigen Netze hängen im Wind, bis ein Sturm sie zerreißt oder mitnimmt.

Zusammen mit Forschungsorganisationen wie dem Institut für Textil- und Verfahrenstechnik in Denkendorf, wissenschaftlich begleitet von der Universität München und mit Unterstützung des Entwicklungshilfeministeriums sowie einiger Sponsoren wurden in einer Versuchsanlage in Marokko Nebelfänger getestet, und weiterentwickelt, die einen hohen Ertrag mit mechanischer Robustheit verbinden sollen. In Marokko konnten auf einer Fläche von 9 m² 600l Wasser am Tag „geerntet“ werden.

Literatur:

www.wasserstiftung.de/en/cloudfisher/

www.wasser.eu/cloudfisher/

www.youtube.com

www.aqualonis.com

(DGMT-Ticker 2/2019 N. Scharnagl)

Wie ein Rasterlektronenmikroskop Elemente erkennt - die EDX-Analyse

Wie beim Transmissions-Elektronenmikroskop wird auch beim Rasterelektronenmikroskop REM der Elektronenstrahl von einer beheizten Kathode bzw. einem Feldemitter als Strahlungsquelle erzeugt. Im REM wird jedoch nicht das ganze Objekt ausgeleuchtet, sondern der Elektronenstrahl wird auf einen kleinen Punkt an der Oberfläche des Objekts fokussiert. Die von diesem Punkt gestreuten Elektronen werden von einem Detektor gesammelt. Das dabei entstehende Signal wird verstärkt und auf einer Bildröhre als Punkt abgebildet.

Ein Rastergenerator führt den Elektronenstrahl des Mikroskops Punkt für Punkt über die Oberfläche des Objekts (deutsch: „rastern“, engl.: „scanning“). Die Ortsinformation des Rastergenerators und die Intensität des Detektorsignals für die abgerasterten Punkte werden entweder direkt auf einem Bildschirm oder über ein geeignetes Rechnersystem zur Generierung eines Bildes genutzt.

Während der Elektronenstrahl die Oberfläche der zu untersuchenden Probe abtastet, ereignen sich elastische und inelastische Streuprozesse in einem vom Probenmaterial und der eingesetzten Beschleunigungsspannung abhängigen Volumen, dem Wechselwirkungsvolumen (Abb.1). Aus diesen Streuprozessen resultiert eine Vielzahl von Signalen unterschiedlicher Energie und somit unterschiedlicher Signalaustrittstiefe. Für die Bildgebung im REM werden in der Regel Rückstreuelektronen (BSE – backscattered electrons) und Sekundärelektronen (SE secondary electrons) genutzt. Die Signalaustrittstiefe ist abhängig von dem Probenmaterial und der Energie des Signals (Abb.1).

Abb. 1: Monte-Carlo-Simulation zur Eindringtiefe von Elektronen bei verschiedenen Beschleunigungsspannungen

Sekundärelektronen mit einer Energie zwischen 0 und

50 eV haben im Probenmaterial nur eine Reichweite von wenigen nm, während Rückstreuelektronen mit einer sehr breiten Energieverteilung, die bis zur Energie des eingestrahlten Elektronen reicht, aus einem wesentlich größeren Volumen der Probe emittieren können. Im Sekundärelektronenkontrast entsteht ein topografisches Bild der Probenoberfläche, der Rückstreuelektronendetektor ermöglicht einen Elementenkontrast, bei dem schwere Elemente heller als leichte dargestellt werden. Zur Mikrobereichsanalyse kann die ebenfalls aus dem angeregten Volumen emittierte Röntgenstrahlung genutzt werden. Mit einem energiedispersiven (EDX - Energy Dispersive X-ray Analysis) bzw. einem wellenlängendispersiven (WDX - Wavelength Dispersive X-ray Analysis) Röntgendetektor lässt sich dich Charakteristische Röntgenstrahlung aus dem angeregten Volumen bestimmen und bei geeigneter Probengeometrie so eine quantitative Analyse der Probe berechnen.

Beim EDX wird der verwendete Elektronenstrahl beim Auftreffen auf eine Probe abgebremst. Dabei regt er in den Atomen der Probe Elektronenübergänge an, die Röntgenstrahlung mit einer für jedes chemische Element charakteristischen Energie aussenden. Diese emittierte Röntgenstrahlung wird mit einem Halbleiterdetektor erfasst und ermöglicht die Analyse der chemischen Zusammensetzung einer Probe.

Das Verfahren erlaubt die Identifizierung - und bei geeigneter Probengeometrie auch die Quantifizierung - aller Elemente ab Ordnungszahl 4 (Be

- Berylium). Diese Variante der Röntgenfluoreszenzanalyse wird als energiedispersive Röntgenanalyse (EDX) bezeichnet, häufig wird allerdings auch die Bezeichnung EDS-Analyse verwendet (Energiedispersive Spektralanalyse) oder ESMA (Elektronenstrahl -Mikroanalyse). Die Kombination der bildgebenden Elektronenmikroskopie mit EDX ermöglicht in einer simultanen Untersuchung hochaufgelöste Detailaufnahmen einer Probe und Aussagen über ihre chemische Zusammensetzung, wobei auch heterogene Bestandteile oder ungleichmäßige Elementverteilungen sowie selbst kleine Einschlüsse von nur wenigen μm-Größe gezielt untersucht werden können.

Abb. 2: a) REM einer Polymeroberfläche; b) Si-EDX Mapping der Fläche von a) (Si: violett)

Literatur:

[1] Scharnagl, N., & Schossig, M. (2005). Chemie Ingenieur Technik, 77(5), 517-526.

[2] Mata, D., Scharnagl, N., Lamaka, S. V., Malheiro, E., Maia, F., & Zheludkevich, M. L. (2018). Corrosion Science, 140, 307-320.

(DGMT-Ticker 1/2019 N. Scharnagl)

Wohlfühl-Membranen - Enthalpie Wärmetauscher

Ein Enthalpie-Wärmetauscher ist in der Lage, Feuchtigkeit aus der Abluft in den frischen Zuluftstrom einer Klimatisierung zu übertragen. Es handelt sich bei dieser Art „Feuchte-Rückgewinner“ um einen Wärmetauscher mit einer Polymermembran als Trennschicht der Luftströme für Zu- und Abluft. Für den Feuchtigkeitstransport wird das physikalische Grundprinzip der Diffusion von Wasserdampf durch eine Polymerschicht genutzt. Das Prinzip unterscheidet sich grundsätzlich von anderen feuchteübertagenden Rotations-Wärmetauschern oder Geräten mit Umluftbetrieb. Das Polymer ist aufgrund einer speziellen, antimikrobiellen Beschichtung (Microban®; www.biocote.com) undurchlässig für Mikroben aller Art. Somit ist die Hygiene auch dann in Wohnungen gewährleistet, wenn Abluft aus Küchen- und Sanitärbereichen über den Wärmetauscher geführt wird.

Gegenüber einem Standard-Wärmetauscher sinkt der Wärmebereitstellungsgrad der Wärmeübertragung etwas ab, jedoch erwirkt die im Wasserdampf gespeicherte Energie eine verbesserte energetische Gesamtbilanz der Wärmerückgewinnung.

Der Vorteil eines Enthalpie Wärmetauschers ist die deutliche Erhöhung des Wohnkomforts, da neben der Wärme auch Feuchte zurückgewonnen wird. Der enthalpische Wärmebereitstellungsgrad liegt bei bis zu 120 %, dabei können 60-70 % der Feuchte zurückgewonnen werden.

Prinzip eines Entahlpie-Wärmetauschers (©Vaillant)

(DGMT-Ticker 2/2018 N. Scharnagl)

Röntgenphotoelektronen Spektroskopie (XPS) oder die „wahre Oberfläche“

Die Röntgenphotoelektronenspektroskopie (englisch: X-ray photoelectron spectroscopy, XPS, oft auch electron spectroscopy for chemical analysis, ESCA) zählt heutzutage zu den wichtigsten Methoden der Materialwissenschaften. Die Charakterisierung von Metallen, Halbleitern und Polymeren sind von großem Interesse für Wissenschaft und Industrie. XPS ist eine etablierte Methode, um die chemische Zusammensetzung vor allem von Festkörpern bzw. deren Oberfläche zerstörungsfrei zu bestimmen. Man erhält dabei zunächst eine Antwort auf die Frage der qualitativen Elementanalyse, also aus welchen chemischen Elementen der Festkörper besteht. Lediglich Wasserstoff und Helium können aufgrund geringer Wirkungsquerschnitte im Allgemeinen nicht nachgewiesen werden.

Die Idee der Messmethode beruht auf dem photoelektrischen Effekt (s Abb. 1). Die Entdeckung des photoelektrischen Effekts verdanken wir den Arbeiten von Hertz, Hallwachs, Thomson, Planck und Einstein (Ende 19. und Anfang 20. Jahrhundert). Planck erhielt 1918 den Nobelpreis für die „Theorie der Quantelung der Energie“. Einstein benutzte Plancks Theorie zur Erklärung verschiedener physikalischer Phänomene, unter anderem auch des photoelektrischen Effekts und erhielt dafür 1921 den Nobelpreis.

Abb. 1: Der Photoionisationsprozess und mögliche Relaxationsmechanismen

Eine weitere wesentliche Information der XPS Spektren, die über die chemischen Bindungsverhältnisse in der Probe, beruht auf der Entdeckung von Kai Siegbahn, dass die Spektren der Rumpfelektronen von der chemischen Umgebung des untersuchten Systems abhängen. Er entwickelte, basierend auf den Überlegungen von Planck und Einstein, in den 1950er und 1960er Jahren die Technologie und Theorie zur Messmethode, auf der heute noch moderne XPS-Anlagen basieren. In den XP-Spektren desselben Elementes zeigen sich je nachdem, in welcher chemischen Form es vorliegt, Unterschiede in der Bindungsenergie eines Rumpfelektrons von bis zu einigen Elektronenvolt, dies wird als chemische Verschiebung (engl. chemical shift) bezeichnet. Beispielsweise kann auch über die Ermittlung von Ladungsverteilungen in einer chemischen Verbindung bestimmt werden, welchen Oxidationszustand ein Atom oder eine Atomgruppe besitzt. Zusätzlich kann in vielen Fällen auch die Form der Spektren Aufschluss über den Valenzzustand eines Elementes geben.

Bei XPS-Untersuchungen wird (nicht)monochromatische Röntgenstrahlung, mit einer charakteristischen Energie, auf eine Probe geschossen (s Abb. 2). Die Photonen lösen Elektronen aus den ersten 1 - 10 nm der Probenoberfläche aus. Danach besitzen die Elektronen eine kinetische Energie EKin und bewegen sich durch das Ultrahochvakuum (UHV) Richtung Energieanalysator mit Detektor. Das resultierende Spektrum zeigt die kinetische Energie bzw. Bindungsenergie der Elektronen. Diese ist charakteristisch für die Orbitale, aus denen die Elektronen emittiert wurden. Die Bindungsenergie lässt sich direkt aus der kinetischen Energie und der Anregungsenergie der Röntgenquelle bestimmen.

Abb. 2: XPS (ESCA) Messprinzip

(DGMT-Ticker 1/2018 N. Scharnagl)

Mikroschadstoffe im Wasser

Eigentlich könnten wir mit der ständig zunehmenden Qualität unserer Gewässer zufrieden sein – Eigentlich! Wenn da nicht die sog. Mikroschadstoffe

wären. Das Problem: Mit herkömmlicher Kläranlagentechnik können diese Stoffe in der Regel nicht aus dem Abwasser entfernt werden. Durch die immer genauere Analytik wird uns diese Problematik immer deutlicher vor Augen geführt. Was verstehen wir eigentlich unter Mikroschadstoffen? In erster Linie handelt es sich um Stoffe wie Arzneimittel, Röntgenkontrastmittel, Kosmetikprodukte, Zusatzstoffe in Lebensmitteln, Haushaltschemikalien, Biozide, Pestizide und Industriechemikalien sowie deren Abbauprodukte, die über verschiedene Eintragspfade in unsere Gewässer gelangen und dort in sehr geringen Konzentrationen zu finden sind.

Zusätzlich zu den Mikroschadstoffen nimmt die Bedeutung des Themas „Mikroplastik“ stetig zu. Kunststoffe umgeben uns im Alltag ständig. Der

Verbrauch in Deutschland lag 2013 bei etwa 17 Mio. Tonnen, von denen ein Teil wieder als Abfall in die Umwelt kommt, wo er sich anreichert. Beispielhaft sind große Müllstrudel in unseren Ozeanen, welche aus tausenden Plastikteilen bestehen. Der größte dieser Müllstrudel befindet sich im Norden des Pazifischen Ozeans zwischen Hawaii, dem nordamerikanischen Festland und Asien. Seine Größe entspricht etwa zwei Mal der Fläche von Deutschland. Nach Hochrechnungen befinden sich derzeit mehr als 150 Millionen Tonnen Plastikmüll in den Meeren. Als Beispiel, in der Nordsee beträgt der Anteil des Plastikmülls ca. 75% der Gesamtmenge. Ein Teil davon liegt als wenig sichtbare „Mikroplastik“ vor. Dabei handelt es sich um Partikel mit weniger als 5 mm Durchmesser, die zwischen primären und sekundären Materialien unterschieden werden. Primäres Mikroplastik wird gezielt industriell hergestellt und gelangt vor allem über das Abwasser in die Umwelt. Dazu gehören Granulate, welche z. B. in Kosmetik- und Hygieneprodukten wie Duschgels und Peelings zu finden sind. Darüber hinaus umfasst primäres Mikroplastik auch Pellets oder Granulate. Sekundäres Mikroplastik entsteht dagegen beim Zerfall größerer Kunststoffabfälle wie z.B. Verpackungsmaterialien, Plastiktüten oder Netzresten und umfasst auch Mikrofasern, die beim Waschen synthetischer Textilien freigesetzt werden. Gerade erst vor kurzem hat ein Expeditionsteam einen neuen riesigen Plastikmüll-Strudel im Meer entdeckt, diesmal vor den Küsten von Chile und Peru. Der Strudel soll sich über eine Fläche erstrecken, die größer als ganz Mexiko ist.

Wie viel Plastik schwimmt wirklich im Pazifik?

(Foto: CC0 Public Domain / Pixabay.com - giogio55)

Referenzen:

[1] www.kompetenzzentrum-mikroschadstoffe.de

[2] https://www.landtag.nrw.de/Dokumentenservice/portal/WWW/dokumentenarchiv/Dokument/

MMV16-3599.pdf;jsessionid=86DC3B3C0FBBDA0127C0CA4A74A78360.ifxworker

[3] http://de.wessling-group.com/fileadmin/media/Germany/PDFs/Mikroschadstoffe_Grundwasser.pdf

[4] https://utopia.de/plastik-plastikmuell-meer-ozean-pazifik-58881/

(DGMT-Ticker 2/2017 N. Scharnagl)

Wie u.a. Membrantechnik Weine beeinflusst

Weine, Rotwein ebenso wie Weißweine, müssen chemisch stabilisiert, also geschönt werden. Dazu wird ein Teil der im Wein enthaltenen Kolloide entfernt. Kolloide (vor allem Tannine, Anthocyane und andere Phenole sowie Proteine) sind feinste Schwebeteilchen. Sie sind häufig für den ausgefällten dichten Bodensatz in der Flasche verantwortlich. Nicht nur einfache Konsumweine auch hochwertige, feine Weine brauchen ein bestimmtes Maß an Schönung.

Geschönt wird mit tonhaltigen Mineralerden wie Bentonit und eiweißhaltigen Produkten, etwa Gelatine. Häufig wird auch frisches, aufgeschlagenes Hühnereiweiß ins Fass gegeben besonders bei feinen Weinen. Innerhalb weniger Minuten bindet es Tannine und Farbstoffe und bildet großflockige Kolloide, die sich leicht aus dem Wein entfernen lassen. Bentonit eignet sich vor allem, um Proteine zu binden, wird allerdings bei Rotweinen vorsichtig eingesetzt, weil es das Tannin angreift. Alle Schönungsmittel hinterlassen keine oder nur minimale Spuren im Wein. Nach einer EU-Lebensmittelrichtlinie müssen tierische Eiweiße ab 2005 jedoch auf dem Etikett angegeben sein.

Das Filtern des Weins ist eine weitere Möglichkeit, ihn zu stabilisieren. So wird Weißwein häufig schon beim Abstich von der Hefe, Rotwein nach dem Abzug von der Maische filtriert. Man benutzt dafür grobe Schichtenfilter, die aus Zellulose, Kieselgur (fossile Kieselalgen) oder Perlit bestehen glasartiger Filterstoff, überwiegend aus Aluminiumsilikat). Mit ihnen wird der Wein von seinen groben Bestandteilen befreit. Diese Filter ersetzen Siebe und Tücher, mit denen schon die Sumerer ihren Wein zu klären pflegten. Danach wird der Wein normalerweise erst wieder vor der Füllung gefiltert. Für diese Feinfiltration werden heute Membranfilter eingesetzt. Bei Weiß- und jungen Rotweinen ist eine Feinfiltration notwendig. Bei lange im Fass ausgebauten Rotweinen ist sie umstritten, weil der Wein sich durch Absetzen bereits weitgehend selbst geklärt hat. Einige Erzeuger hochwertiger Rotweine versuchen, ohne Filtration auszukommen, um den Wein nicht wichtiger Geschmacksträger zu berauben. Darin liegt immer das Risiko, dass der Wein sich später auf der Flasche unerwartet oder nicht optimal entwickelt.

Zu heftigen Diskussionen führen die seit einigen Jahren angewandten „Neuen ökologischen Verfahren“. Dazu gehören die Konzentrierungsverfahren; weinethische Grundsätze prallen auf marktwirtschaftliche Fragen, der Wunsch nach Chancengleichheit im internationalen Wettbewerb wird laut und ringt gegen den Fortbestand der nationalen Traditionen.

Abb 1: (C) Gadini

Eine Alternative zu den bisherigen Chaptalisierung mittels Saccharose oder dem Einsatz von Rektifiziertem Traubenmostkonzentrat (RTK) stellt die Mostkonzentrierung durch Wasserentzug dar, da neben dem Zuckergehalt auch alle übrigen Mostinhaltsstoffe aufkonzentriert werden.

Ein weiterer positiver Aspekt stellt die Konzentrierung der Aromakomponenten, die den Most dichter in der Struktur erscheinen lässt, und die Intensivierung der Farbe speziell bei Rotweinen dar.

Auf europäischer Ebene ist die Konzentrierung bereits zugelassen (Verordnung (EG) Nr. 1493/1999). Dabei kommen in der Regel drei Verfahren zum

Einsatz:

• Vakuumverdampfung

• Gefrierkonzentrierung

• Umkehrosmose

Aber nicht nur bei der Konzentrierung spielt die Membrantechnik eine wichtige Rolle. In zunehmendem Maße tritt auch der Alkoholgehalt in den Focus. So werden verschiedene Verfahren angewandt, um die Alkoholkonzentration zu verringern:

| Thermische Verfahren | Destillation unter Vakuum Destillation unter Normaldruck |

| Membranverfahren | Umkehrosmose Dialyse Pervaporation |

| Extraktionsverfahren | organische Lösungsmitte Hochdruckextraktion mit fluidem CO2 |

| Absorptionsverfahren | Harze Kieselgelee |

Referenzen:

[1] https://www.google.de/url?sa=t&rct=j&q=&esrc=s&source=web&cd=6&ved=0ahUKEwirpPeVqabTAhXjJsAKHdZmD_kQFgg5MAU&url=http%3A%2F%2Fdaten.schule.at%2Fdl%2FJS-Neue_Vinifikationsmethoden.doc&usg=AFQjCNHL-YK0l8rARDqplHqpsPogzVfRgw&cad=rja

[2] https://de.wikipedia.org/wiki/Getränkefiltration

(DGMT-Ticker 1/2017 N. Scharnagl)

BET – Wie Stickstoff die Oberfläche bestimmt

BET ist ein verbreiteter Begriff für ein Analyseverfahren zur Größenbestimmung von Oberflächen, insbesondere von porösen Festkörpern, und zur Porenanalyse mittels Gasadsorption. Eigentlich handelt es sich nicht um die Messung, sondern vielmehr um die Methode, mit welcher die spezifische Oberfläche (m²/g) aus den experimentellen Daten errechnet wird. „BET“ steht dabei für die Namen Stephen Brunauer, P. H. Emmett und Edward Teller, den Entwicklern des BET-Modells1. Bei der Methode wird die Tatsache ausgenutzt, dass Gase und Dämpfe (Adsoprtiv) unter Freisetzung der (messbaren) Adsorptionswärme zunächst in einer monomolekularen Schicht von der Oberfläche (Adsorbens) adsorbiert werden (Chemiesorption); darauf bilden sich dann durch unspezifische physikalische Wechselwirkungen weitere Schichten (Physisorption). Allerdings ist dieser Vorgang nicht zu verwechseln mit Kondensation, da der Sättigungsdampfdruck nicht erreicht wird. Eine Kondensation würde das Messergebnis verfälschen.

Abb 1: Adsorptionsisotherme nach BET

Abb 1: Adsorptionsisotherme nach BET

In der Praxis kühlt man einen Feststoff auf eine konstante Temperatur ab und dosiert eine bestimmte Menge Gas in den Probenraum, so lagert sich ein Teil der Gasmoleküle an der Oberfläche an. Aus praktischen Erwägungen hat sich als Standardmethode die Stickstoffadsorption bei der Temperatur von Flüssigstickstoff (-196 °C, 77K) durchgesetzt.

Mit Hilfe der BET-Gleichung (Gl. 1) wird aus der adsorbierten Gasmenge die Menge an Adsorbat berechnet, die auf der Oberfläche eine Monoschicht, ausbildet.

Die für die Auswertung günstigere linearisierte Form ergibt sich zu:

Dies ist die Gleichung einer Geraden γ = ax+b

Die Anzahl der Mol in der Monoschicht Vm multipliziert mit der Avogadrozahl NA und dem Platzbedarf eines Moleküls (Stickstoff: am = 0.162 nm2) ergibt die BET-Oberfläche Osp (Gl. 3)

Osp = Vm • am • NA (Gl. 3)

Die der Ableitung der BET-Isotherme zugrundeliegenden Voraussetzungen sind bei realen Adsorbaten allerdings nicht erfüllt und widersprechen sich auch teilweise. Trotzdem erhält man Geraden entsprechend (Gl. 2), gewöhnlich aber nur, wenn man sich auf den sogenannten BET-Bereich (0.05 < p/p0 < 0.30) beschränkt. Hier kompensieren sich die bei der Ableitung gemachten Fehler größtenteils.

Referenzen:

[1] Brunauer, S., Emmett, P.H., Teller, E., "Adsorption of Gases on Multimolecular Layers", J.Am.Chem.Soc., 60, S. 309-319, 1938

[2] DIN ISO 9277:2003-05 Bestimmung der spezifischen Oberfläche von Feststoffen durch Gasadsorption nach dem BET-Verfahren (ISO 9277:1995).

(DGMT-Ticker 2/2016 N. Scharnagl)

Kontaktwinkelmessung – Die Geschichte eines Tropfens

Bei einer Grenzfläche zwischen einer Flüssigkeit und einem Feststoff wird der Winkel zwischen der Flüssigkeitsoberfläche und dem Umriss der Kontaktfläche als Kontaktwinkel θ bezeichnet. Der Kontaktwinkel ist ein Maß für die Benetzbarkeit eines Festkörpers durch eine Flüssigkeit, wobei Benetzbarkeit das Bestreben eines Festkörpers beschreibt, mit einer in Kontakt tretenden Flüssigkeit eine gemeinsame Grenzfläche zu bilden. Der Kontaktwinkel ist überall dort wichtig, wo die Intensität des Phasenkontakts zwischen flüssigen und festen Stoffen kontrolliert oder bewertet werden soll: hydrophobe oder hydrophile Beschichtung, Coating, Lackierung, Reinigung, Drucken, Kleben, Dispergierung und natürlich in der Membrantechnik.

Die Messung des Kontaktwinkels mit einer oder mehreren Flüssigkeiten kann zur Bestimmung der freien Oberflächenenergie eines Festkörpers herangezogen werden. Durch Variation der Messflüssigkeit können die polaren und unpolaren Anteile der Oberflächenenergie berechnet werden (vergl. Wilhelmy-Platten-Methode, s.u.).

Grundsätzlich kommen verschiedene Methoden bei der Kontaktwinkelbestimmung zum Einsatz. Am häufigsten ist das Aufsetzen eines Flüssigkeitstropfens auf eine Oberfläche, die so genannte Tropfenkonturanalyse mit einem liegenden Tropfen. Der Kontaktwinkel wird anhand des Bildes des liegenden Tropfens an den Schnittpunkten (Dreiphasenpunkten) zwischen der Tropfenkontur und der Projektion der Oberfläche (Basislinie) gemessen. Dieser Kontaktwinkel θ wird durch die Oberflächenspannung des Festkörpers und der Flüssigkeit sowie durch die Grenzflächenspannung zwischen Festkörper und Flüssigkeit bestimmt (Abb. 1).

Abb 1: Grenzflächenspannungen am Dreiphasenkontakt. γl, γs: Oberflächenspannungs-

komponenten der Flüssigkeit und des Festkörpers, γsl: Grenzflächenspannung zwischen

beiden Phasen (Quelle: Skript pc4_03_kontaktwinkel.pdf der Uni-Marburg)

Abb 2: Kontaktwinkel bei unterschiedlicher Hydrophilie

(Quelle: Westfälische Hochschule, FB12, Labor für Oberflächenchemie)

Dabei gilt nach YOUNG:

γsg = γsl + γlg • cos θ

Mit zunehmender Benetzbarkeit der Oberfläche nimmt der Kontaktwinkel ab. Bei der Verwendung von Wasser als Flüssigkeit bezeichnet man bei geringen Kontaktwinkeln (ca. 0°) die Oberfläche als hydrophil, bei Winkeln um 90° als hydrophob und bei noch größeren Winkeln als superhydrophob. Letzteres wird bei sehr hohen Winkeln (> 160°) auch als Lotuseffekt bezeichnet und entspricht einer extrem geringen Benetzbarkeit.

Eine besondere Methode wird häufig bei Festkörpern mit einer hohen freien Obeflächenenergie angewandt. Statt wie beim liegenden Tropfen wird hier eine Luftblase unterhalb des Festkörpers, der sich in einer Flüssigkeit befindet, platziert und zur Konturanalyse herangezogen. Diese Anordnung wird als Captive-Bubble-Methode bezeichnet (s. Abb 3).

Abb 3: Captive Bubble: Luftblase unterhalb einer Oberfläche

(Quelle: Krüss www.kruss.de)

Durch spezifische Oberflächenbehandlung kann der Kontaktwinkel verändert werden, hydrophobe Oberflächen sind wasserabweisend. Sehr genau definierte und erzeugte Formen der Oberflächenstrukturierung erlauben die Bildung von omniphobe Eigenschaften, die sowohl hydrophob als auch lipophob sind.

Wilhelmy-Plattenmethode: Bei der senkrechten Bewegung eines plattenförmigen Festkörpers aus einer Flüssigkeit in Zugrichtung wirkt eine Kraft, die gemessen wird. Außer von der Oberflächenspannung und von der benetzten Länge hängt diese Kraft vom Kontaktwinkel ab.

(DGMT-Ticker 1/2016 N. Scharnagl)

Thermische Trennverfahren mit Membranen – Die Membrandestillation

In der Regel beruht das Prinzip der Stofftrennung mittels Membranen auf treibenden Kräften wie Druckdifferenz, Konzentrationsgefälle oder elektrischem Feld. Dabei sind für die Trennqualität (Selektivität) der entsprechenden Membranen die Porengrößen, die Löslichkeiten oder Diffuionskoeffizienten eines Stoffes oder die elektrische Polarität, um nur ein paar zu nennen, entscheidend.

Bei der Membrandestillation erfolgt der Stofftransport mittels eines Phasenwechsels und eines Dampfdruckgefälles (Partialdampfdruck) [1]. Während die Flüssigphase auf der einen Seite einer porösen Membran zurückgehalten wird, kann die Dampfphase die Membran passieren, z.B. wird Wasser bei einer stark hydrophoben Membran zurückgehalten, während der Wasserdampf hindurch permeiert. Dabei wird die Partialdruckdifferenz durch eine Temperaturdifferenz hervorgerufen.

Trotz der relativ großen Poren solcher Membranen kommt es auf Grund der unterschiedlichen Polaritäten von Membran und Medium sowie durch die, im Falle von Wasser, hohe Oberflächenspannung nicht zu einem durchtreten der Flüssigkeit durch die Membran (Kapillardepression: Entgegenwirken von Adhäsions- und Kohäsionskräften). Wird der Druck auf der Flüssigkeitsseite jedoch zu hoch, kann es zum Durchbrechen der Flüssigkeit kommen.

Derzeit von technischer Bedeutung sind Verfahren, die sich durch den Aufbau des Destillatkanals oder durch die Betriebsweisen unterscheiden. In der Regel findet das Verfahren Anwendung bei der Wasseraufbereitung, der Stoffstromrückgewinnung oder der Wertstoffaufkonzentration. Etwas kurios ist die Anwendung zur Gewinnung von Trinkwasser aus Körper eigenem Schweiß mittels einer "Sweat-Machine"[3].

Abb 1: Schema Membrandestillations-Prozess von Joachim Koschikowski [2]

Referenzen:

[1] Onsekizoglu, P.; Membrane distillation: principle, advances, limitations and future prospects in food industry From "Distillation: Advances from Modeling to Applications" (2012), 233-266 DOI:10.5772/37625

[2] Joachim Koschikowski - Entwicklung von energieautark arbeitenden Wasserentsalzungsanlagen auf Basis der Membrandestillation Fraunhofer Verlag, 2011, 3839602602. Lizenziert unter CC BY-SA 3.0 über Wikimedia Commons

[3] www.chemie.de/news/144173/sweat-machine-verwandelt-schweiss-in-trinkwasser.html

(DGMT-Ticker 2/2015 N. Scharnagl)

Isoporöse Polymermembranen – Herstellung definierter Porengrößen

In der Membrantrenntechnik sind poröse Membranen nicht wegzudenken. Anwendungen in der Wasseraufbereitung, der Lebensmittelbranche und der Medizintechnik nutzen Filtrationsmembranen. Dabei spielt die Porengröße und die Porenverteilung eine wesentliche Rolle für die Effizienz der Anwendung. Sehr enge Porenverteilungen mit definierter Porengröße sind dabei in der Regel keramischen oder metallischen Substraten vorbehalten.

Im vergangenen Jahr ist es Membranforschern im Rahmen eines EU-Projektes gelungen, nahezu isoporöse Polymermembranen mit variabler Porengröße herzustellen [1]. Dabei macht man sich zu Nutze, dass sog. Block-Copolymere mit Tendenz zur Phasensegregation unterschiedliche regelmäßige Strukturen auf einer Größenskala im Nanometerbereich ausbilden können. Diese Strukturen werden beeinflusst durch die Zusammensetzung, dem Polymerisationsgrad und den Phasen (amorph, kristallin) der jeweiligen Polymerblöcke.

Stellt man Filme aus diesen Block-Copolymeren her und unterzieht diese Filme einer Nachbehandlung (z.B. Ätzen oder Herauslösen von Additiven) lassen sich definierte Porengrößen erzielen. Eine weitere Toolbox zu Variation von Porengrößen ist die Herstellung solcher Filme aus Block-Copolymer-Blends (Mischungen). Dadurch lassen sich, vereinfacht ausgedrückt, Zwischengrößen der Poren erzeugen, die im Rahmen der Porengrößen der jeweiligen einzelnen Block-Copolymeren liegen.

Den Forschern ist es nicht nur gelungen, die Porengrößen im Bereich von 21 bis 46 nm zu variieren, sondern auch, diese extrem dünnen Polymerfilme auf ein polymeres Trägersubstrat zu übertragen. Letzteres sollte die Herstellung in technischem Maßstab ermöglichen.

Abb 1: Rasterelektronenmikroskopische Aufnahme der Oberfläche einer isoporösen Polymermembran

(© Helmholtz-Zentrum Geesthacht GmbH, Institut für Polymerforschung)

Referenzen:

[1] Maryam Radjabian and Volker Abetz, Tailored Pore Sizes in Integral Asymmetric Membranes Formed by Blends of Block Copolymers. Advanced Materials, 2015. 27(2): p. 352-355.

(DGMT-Ticker 1/2015 N. Scharnagl)

Membranen retten Leben – Anwendung in der Medizintechnik

Nachdem in der letzten Ausgabe des TICKER Membranen mit schaltbaren Eigenschaften vorgestellt wurden, soll heute das Thema Membranen in der Medizintechnik angerissen werden. Die Einsatzgebiete der unterschiedlichen Membranen in der Medizintechnik reichen von der Dialyse über Oxygenatoren bis hin zu Drug-Delivery Systemen. Sogar Rückgewinnungssysteme für Narkosegase wie Xenon wurden untersucht. Der größte Anteil der jährlich weltweit produzierten Membranfläche wird heute in der Dialyse eingesetzt, die den größten Markt an technischen Membrananwendungen darstellt. Mehrere hundert Millionen km Hohlfasermembranen werden jährlich für die künstliche Niere produziert und erlauben die Behandlung von weit mehr als 1 Million Dialysepatienten[1].

In einer Herz-Lungen-Maschine wird der Membran als Blutoxygenator eine entscheidende Funktion zuteil. Als Trennung zwischen Blut und Gas kommt es aufgrund des Konzentrationsgefälles zum Austausch von Sauerstoff und Kohlendioxid, gleichzeitig wird der direkte Blutkontakt des Gases vermieden, wodurch der bluttraumatisierende Effekt reduziert wird. Durch den Einsatz der künstlichen Lunge werden Operationen am "offenen Herzen" ermöglicht. Heutzutage werden fast alle Oxygenatoren als Hohlfaden-Membran-Oxygenatoren gebaut.

Abb 1: Skizzierte Funktionsweise einer Herz-Lungen-Maschine (Quelle: www.herz.at)

Ein Forscherteam des Max-Planck-Instituts für Polymerforschung hat eine neue Art Membran entwickelt, mit der Gase wie Kohlendoxid nach Wunsch in Flüssigkeiten und Gasen angereichert oder aus ihnen herausgelöst werden können. Die Fähigkeiten der Membran beruhen auf einer stark flüssigkeitsabweisenden (superamphiphoben) Beschichtung, die nicht nur den Gasaustausch verbessert sondern gleichzeitig ihre Poren vor Verstopfung schützt.[2]

Wie stimuli-sensitive Membranen in der Medizintechnik eingesetzt werden können, zeigt ein im Mai erschienener Artikel in "Advanced Functional Materials". Schweizerische Forscher haben ein Pflaster entwickelt, dass Wirkstoffe kontinuierlich über eine Membran abgibt, wenn es mit UV-Licht bestrahlt wird.[3]

Weiterhin werden Membranen in verschiedensten Organunterstützungssystemen eingesetzt, wie z.B. in der künstlichen Leber, Bauchspeicheldrüse, Haut oder Augenlinse. Auch neben eigentlichen Körperfunktionen kommen Membranen zum Einsatz. So wurde von der Deutschen Bundesstiftung Umwelt (dbu) in den Jahren 1993 bis 1996 ein Projekt der Univ. Ulm zur Rückgewinnung von Xenon als Narkosegas gefördert. Xenon hat gegenüber herkömmlichen Narkosegasen einige Vorteile, aber ist erheblich teurer. Das Membran-Rückgewinnungsverfahren hat sich als nicht wirtschaftlich herausgestellt und andere Methoden befinden sich derzeit in der Erprobung. Der Gebrauch halbgeschlossener Niedrigflussnarkosegeräte könnte in Zukunft den ökonomischen Einsatz Xenons signifikant verbessern.[4]

Dies sind nur einige Beispiele, wie Membranen Leben retten bzw. dazu beitragen können, lebensrettende Maßnahmen zu ermöglichen.

Referenzen:

[1] B. Krause, H. Göhl, and F. Wiese, Medizintechnik, in Membranen: Grundlagen, Verfahren und industrielle Anwendungen, K. Ohlrogge and K. Ebert, Editors. 2006, Wiley-VCH Verlag GmbH & Co KGaA, Weinheim.

[2] M. Paven, et al., Super liquid-repellent gas membranes for carbon dioxide capture and heart–lung machines. Nat Commun, 2013. 4.

[3] K. Schöller, et al., From Membrane to Skin: Aqueous Permeation Control Through Light-Responsive Amphiphilic Polymer Co-Networks. Advanced Functional Materials, 2014. 24(33): p. 5194-5201.

[4] A. Brucken, et al., Aktuelle Entwicklungen in der Xenonforschung. Anaesthesist, 2010. 59(10): p. 883-95.

(DGMT-Ticker 2/2014 N. Scharnagl)

Formgedächtnis Polymere = Polymer-Membranen mit schaltbaren Eigenschaften?

Formgedächtnis Polymere (Shapememory Polymere, SMPs) sind auf einen äußeren Reiz reagierende, formverändernde Materialien. In den letzten Jahren wurden erhebliche Fortschritte in der Synthese und Charakterisierung von SMPs erzielt [1]. Sie können durch eine temporäre Fixierung zu einer vorgegebene Geometrie programmiert werden, die in den Aussgangszustand zurück geht, sobald ein externer Reiz auftritt. In den meisten Fällen ist der Stimulus Wärme, aber auch andere Reize, wie elektrischer Strom, Luftfeuchtigkeit, Licht oder magnetische Wechselfelder, sind realisiert worden. Der Effekt basiert nicht auf einer intrinsischen Materialeigenschaft sondern auf der Funktionalität des Materials. Es erfordert die Kombination einer geeigneten molekularen Polymer-Netzwerk-Architektur mit einer ausreichend elastische Verformbarkeit und einer maßgeschneiderte "Programmierung". Im Allgemeinen bestehen diese polymeren Netzwerke aus schaltbaren Segmenten, die durch Netzwerkpunkte, welche die permanenete Form bestimmen, miteinander verbunden sind. Die Netzwerkpunkte können chemische (kovalente) Bindungen oder intermolekulare Wechselwirkungen sein. Die meisten der SMPs sind Zwei-Form-Materialien, die einen einfachen Wechsel von einer temporären zu einer permanenten Form ermöglichen. In der jüngsten Vergangenheit wurden Dreifach-Form-Polymere, die zwei Übergänge realisieren, sowie Multi-Form Polymere, mit mehreren Form-Übergängen, vorgestellt [2].

Abb 1: Schema einer "Formgedächtnis-Membran" mit schaltbaren Porengrößen für die Filtration

All diese Vorgänge sind in der Regel aber nicht reversibel, so dass der Schaltvorgang immer nur in einer Richtung abläuft. Mit der Entwicklung von reversiblen, bidirektionalen Formgedächtnis Polymeren eröffnen sich neue Wege für die Membrantechnik [3].

Zum Beispiel steuert u. a. die Größe des in Membranmaterialien verfügbaren freien Volumens die Permeabilität bei Gas-Diffusions-Membranen. Mit diesem Hintergrund wurden aus thermosensitivem Polyurethan (TSPU) Membranen synthetisiert, deren Wasserdampfpermeabilität über die Temperatur steuerbar ist [4]. Auch im Bereich der Filtrationsmembranen wurden in den letzten Jahren Forschungsarbeiten veröffentlicht, bei denen durch Verwendung von Stimuli sensitiven Materialien gezielt die Porengröße beeinflusst wird [5-7].

Referenzen:

[1] A. Lendlein and T. Sauter, Shape-Memory Effect in Polymers. Macromolecular Chemistry and Physics, 2013. 214(11): p. 1175-1177.

[2] Q. Zhao, M. Behl, and A. Lendlein, Shape-memory polymers with multiple transitions: complex actively moving polymers. Soft Matter, 2013. 9(6): p. 1744.

[3] M. Behl, et al., Reversible bidirectional shape-memory polymers. Adv Mater, 2013. 25(32): p. 4466-9.

[4] Y. Chen, et al., The polyurethane membranes with temperature sensitivity for water vapor permeation. Journal of Membrane Science, 2007. 287(2): p. 192-197.

[5] J.I. Clodt, et al., Double Stimuli-Responsive Isoporous Membranes via Post-Modification of pH-Sensitive Self-Assembled Diblock Copolymer Membranes. Advanced Functional Materials, 2013. 23(6): p. 731-738.

[6] T. Sauter, K. Kratz, and A. Lendlein, Pore-Size Distribution Controls Shape-Memory Properties on the Macro- and Microscale of Polymeric Foams. Macromolecular Chemistry and Physics, 2013. 214(11): p. 1184-1188.

[7] F. Schacher, M. Ulbricht, and A.H.E. Müller, Self-Supporting, Double Stimuli-Responsive Porous Membranes From Polystyrene-block-poly(N,N-dimethylaminoethyl methacrylate) Diblock Copolymers. Advanced Functional Materials, 2009. 19(7): p. 1040-1045.

(DGMT-Ticker 1/2014 N. Scharnagl)

"Rust Never Sleeps…" – Korrosion bei der Umkehrosmose zur Wasserentsalzung

"Rust Never Sleeps" ist nicht nur der Titel eines von Neil Young und Crazy H orse 1979 veröffentlichten Musik- Albums, sondern auch ein ewig währender Slogan für Materialwissenschaftler. Bei der Auslegung von Umkehrosmose (RO)-Meerwasserentsalzungsanlagen ist grundsätzlich eine besondere Sorgfalt bei der Auswahl der Materialien notwendig. Diese spielt eine besondere Rolle für die Lebensdauer und Zuverlässigkeit der Anlage. Dazu liegt es auch im primären Interesse der Planer und Betreiber, die Korrosion zu verhindern bzw. zu minimieren. Die wichtigsten Einflussparameter für die Korrosion sind der Chloridgehalt und die Sauerstoffkonzentration des Wassers (besonders im Retentat), der hohe Druck und die erhöhte Wassertemperatur, insbesondere in den wärmeren Regionen der Welt. Daher sind hochlegierte Edelstähle bei dieser Anwendung im Einsatz.

In den meisten Korrosionsschadensfällen wurden Stähle verwendet, die für die spezifische Anwendung eine nicht ausreichende Kontaktkorrosions- oder Lochfraßbeständigkeit aufwiesen. Häufig werden nicht nur Pumpen sondern auch Armaturen / Fittings und Rohrleitungs- systeme geschädigt, wobei neben der mangelnden Korrosionsbeständigkeit häufig auch mangelhafte Materialfertigung (Schweißnaht), Design oder Wartung eine entscheidende Ursache sein können.

Abb 1: Die "korrodierte" NS Otto Hahn nach mehrjährigem Einsatz auf See (Archivbild HZG)

Abb 1: Die "korrodierte" NS Otto Hahn nach mehrjährigem Einsatz auf See (Archivbild HZG)

Salzgehalt und Wassertemperatur werden bei Fragen zur Korrosionsbeständigkeit gerne unterschätzt. Während in Mitteleuropa eine Meerwassertemperatur von unter 20°C als normal einzuschätzen ist, liegt die "normale" Meerwasser- temperatur z. B. im Nahen Osten durchaus über 30°C. Dies erhöht die Anfälligkeit des Materials durch die erhöhte Aktivität z. B. der Chloridionen (und deren gleichzeitig höhere Konzentration im Vergleich zu Mitteleuropa) gegen Lochfraß oder Kontaktkorrosion drastisch. Darüber hinaus kann die Bioaktivität des Seewassers von Region zu Region unterschiedlich sein, vermutlich in tropischen Gebieten eher kritischer. Jedoch liegt der pH-Wert selbst in extremen Fällen (tiefen Mündungen oder Küsten mit hoch produktivem / industriellem Umfeld) zwischen 7.3 und 8.6, was für die Verwendung von Edelstählen unter dem Gesichtspunkt der Korrosion a ls unbedenklich anzusehen ist.

Referenzen:

[1] N. Larche, P. Dezerville and F.D. Le, Corrosion and corrosion management investigations in seawater reverse osmosis desalination plants, Desalin. Water Treat. 51 (2013), 1744-1761.

[2] J.W. Oldfield and B. Todd, Environmental aspects of corrosion in MSF and RO desalination plants, Desalination 108 (1997), 27-36.

[3] d.B.B. Van and C. Vandecasteele, Distillation vs. membrane filtration: overview of process evolutions in seawater desalination, Desalination 143 (2002), 207-218.

(DGMT-Ticker 1/2013 N. Scharnagl)

Wie man das Prinzip der Nylonherstellung für die Membrantechnik nutzt – Phasengrenzflächenpolymerisation

Durch die Reaktion von Sebacinsäuredichlorid (Sebacoylchlorid) mit Hexa-methylendiamin (1,6-Diaminohexan) bildet sich Nylon 610® (Abb. 1). Die beiden Komponenten werden in zwei Lösungsmitteln unterschiedlicher Dichte gelöst, die sich nicht miteinander mischen, hier Wasser und n-Hexan. Eine Reaktion kann daher nur an der Berührungsfläche der beiden Phasen stattfinden. Durch diese Phasengrenzflächenpolymerisation ist es z. B. möglich, kontinuierlich einen Faden aus einem Becherglas zu ziehen.

Abb 1: Reaktionsgleichung zur Herstellung von Nylon 610

Auf diesem Prinzip basierend wurde von Cadotte (FilmTec Corporation [1]) eine sehr wirkungsvolle Methode entwickelt, um extrem dünne, fehlstellenfreie Polymerfilme (< 50 nm) zu erhalten. Als poröse Stützstruktur wird meist eine polymerbasierte Ultra- oder Mikrofiltrationsmembran eingesetzt. Diese Membran wird zunächst in eine wässrige Lösung des hydrophilen Monomers (z. B. Polyethylenimid, PEI) getaucht und vollständig benetzt. Die so vorbereitete Membran wird im nächsten Verfahrensschritt in eine organische Lösung des hydrophoben Monomers (z. B. Toluoldiisocyanat (TDI) in Hexan) getaucht. Es erfolgt an der Phasengrenze zwischen beiden Flüssigkeiten die Polymerisation, da sich das hydrophile Monomer PEI nicht in der organischen Lösung (n-Hexan), und das hydrophobe Monomer TDI nicht in Wasser lösen und so nicht vermischen können. Der sich kontinuierlich bildende, sehr dünne Film lässt die Reaktion schnell abklingen, da beide Monomere diesen Film nicht passieren und damit auch nicht mehr miteinander reagieren können. Durch Erwärmen kann zum einen die Reaktion beschleunigt und zum anderen die mechanische Stabilität der entstandenen Kompositmembran durch den einsetzenden Schrumpfungsprozess erhöht werden. Durch Variation der Monomerkonzentrationen beider Lösungen lassen sich

heutzutage die Eigenschaften der selektiven Schicht je nach Anwendung der Umkehrosmosemembran gezielt einstellen.

Referenz:

[1] Cadotte J.E., Interfacially synthesized reverse osmosis membrane (1981) US Patent 4,277,344.

(DGMT-Ticker 2/2012 N. Scharnagl)

Wie man mit Umkehrosmose-Membranen Energie erzeugen kann – Das Prinzip der Osmose als Energiequelle (Pressure Retarded Osmosis - PRO)